Rückblick auf den Feedbackworkshop zur GND-Dokumentation am 24.11.2025

Mit der sukzessiven Veröffentlichung der Erfassungsregeln für die Normdatensätze der Gemeinsamen Normdatei auf der STA-Dokumentationsplattform im September hat die GND-Kooperative einen großen Schritt hin zur Fortschreibung ihrer Öffnung für die Expertise weiterer Communitykreise getan. In einem Workshop zur GND-Dokumentation bekamen Mitglieder aus Museen, Archiven und Forschungseinrichtungen, die mit der GND arbeiten, Gelegenheit, zu deren Struktur, Bedienfreundlichkeit und Verständlichkeit Feedback zu geben. Die Inhalte und Ergebnisse fasst dieser Blogpost zusammen.

Die Farbfolge eines Regenbogens folgt ganz ohne menschlichen Zutuns den immer gleichen Regeln.

Credit: Andrea Stöckel, public domain via public domain pictures

Von Regeln und ihrem Nutzen

Ein Regenbogen, die Schwerkraft und die Trägheit der Masse folgen den immer gleichen Naturgesetzen - auch wenn uns das Anthropozän gerade hier zum Umdenken zwingt. In zwischenmenschlichen Bereichen helfen Regeln, Konflikte zu vermeiden, Prozesse zu effektivieren und die Zusammenarbeit zu fördern. Oft genug sind es genau die Regeln oder besser die Befolgung derselben, die zu einer besseren Qualität führen. Sei es mehr Sicherheit im Straßenverkehr durch die Straßenverkehrsverordnung oder die Verwendung von genormten Material im Bau. Oder mehr Vergleichbarkeit durch standardisierte Ausschreibungsverfahren oder mehr Gerechtigkeit durch Gesetze, die für alle gelten. Die Reihe ließe sich beliebig fortsetzen. In der digitalen Transformation des Kulturbereichs ebenso in der Wissenschaft und Forschung sollen gemeinsame Standards, letztlich Regeln, für mehr Interoperabilität, Vernetzung und verbesserte Auffindbarkeit beziehungsweise Sichtbarkeit der digitalisierten Inhalte sorgen. Eine besondere Rolle nehmen hier Normdaten ein. Die Daten der Gemeinsamen Normdatei (GND) bieten den Vorteil, dass sie auch unabhängig von dem Stand der Standardisierung insgesamt bereits all das oben Genannte unterstützen. Sie sind sozusagen die Vorhut der Standardisierung. Dies erklärt den hohen Nutzungsgrad der GND-Daten als persistentes Referenzsystem in Kultur und Forschung im deutschsprachigen Raum. (weitere Informationen: Erste Ergebnisse der Umfeldanalyse wurden in Form eines Whitepapers veröffentlicht: Schlösser, M., Schäffer, J., von Hagel, F., & Schäfer, F. (2024). Überblick über das Forschungsdatenmanagement in Museen und Universitätssammlungen. Zenodo. https://zenodo.org/records/13789201)

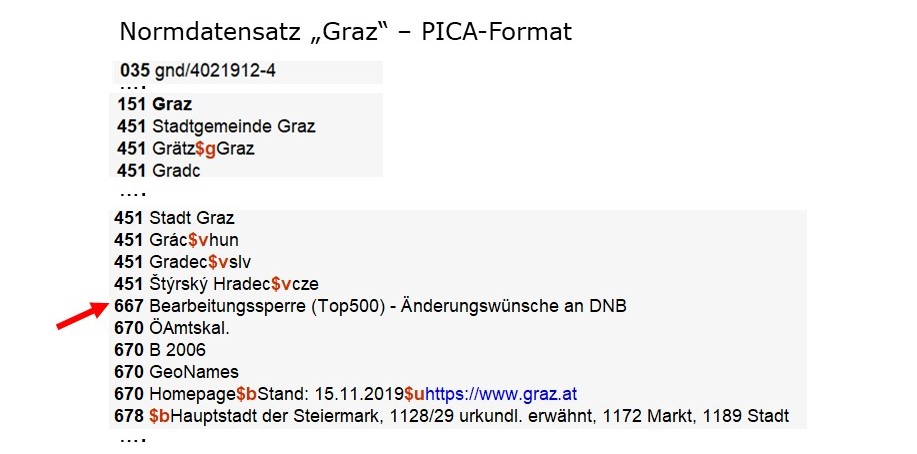

Durch die verstärkte Nutzung der GND-Daten ergeben sich gerade in ihrer bedarfsorientierten Ansetzung auch erhöhte Bedarfe an neuen GND-Datensätzen oder an Ergänzung von bestehenden. Damit jedoch Normdaten ihre Referenzfunktion wirklich erfüllen können, müssen sie verlässlich sein. Diese Verlässlichkeit wird letztlich durch Regeln definiert und garantiert. Die Regeln, nach denen die GND-Datensätze angelegt werden, basieren wiederum auf internationalen Standards, niedergelegt im Regelwerk Resource Description Access – für den deutschsprachigen Raum in der Kurzform RDA DACH genannt. Vor der Veröffentlichung der STA-Dokumentationsplattform regulierte ein Lizenzmodell den Zugang zum RDA-Toolkit, mit dem Erschließende sich im Zweifel über die regelkonforme Darstellung von Katalogsdaten, wie Titel, Autor, Werk oder Ort, informieren konnten. Dieses Toolkit wurde ergänzt durch eine Vielzahl von aufeinander verweisenden und bezugnehmenden Textblättern, den Erfassungsleitfäden und Erfassungshilfen zur GND. Sich in diesem Geflecht zurecht zu finden war schwierig, auch wenn die Textblätter an sich über die Deutsche Nationalbibliothek allgemein zugänglich waren. Es ist daher nur folgerichtig, dass mit der Öffnung der GND auch die Regeln zu ihrer Erfassung transparenter, partizipativer und vor allem lizenzfrei zugänglich gemacht werden mussten. Mit der Veröffentlichung der Erfassungshilfen für Akteure, Geografika und Körperschaften in der GND-Dokumentation sind wir diesem Meilenstein erheblich näher gekommen. In den kommenden Monaten sollen die Regeln für Werke, Konferenzen und Sachbegriffe folgen.

Mit einer Workshopreihe begleitet die GND-Interessengruppe “Museen und Sammlungen” (IG MuS), unterstützt durch Mitarbeitende der GND-Zentrale, den Publikationsprozess. Eine Einführung in die Thematik erfolgte in dem ersten Workshop im Februar. Im Wesentlichen umreissen die beiden ersten Absätze des Blogposts die Perspektive der GND, wie das Thema im Workshop behandelt wurde. Der nebenstehenden Präsentation sind weitere Aspekte zu entnehmen.

Zum Lesen bitte auf die Abbildung klicken.

Vortrag zum ersten Workshop der IG MuS zur GND Dokumentation

Eine Einführung in die Arbeit mit der GND-Dokumentation

Für den Online-Workshop am 24. November konnten sich die Teilnehmenden aus der IG MuS und weitere Interessenten unmittelbar mit der GND-Dokumentation befassen. Dazu war zunächst eine Einführung in die Struktur der STA-Dokumentationsplattform mit ihren Bestandteilen Allgemeines, RDA DACH und GND erforderlich. Dies übernahm Andrea Hemmer (DNB). Sie erläuterte zu Beginn die inhaltlichen Abhängigkeiten zwischen RDA DACH und der GND am Beispiel von den Regeln zur Darstellung von Akteuren. Sie präsentierte unterschiedliche Möglichkeiten zur Suche und allgemein Begrifflichkeiten und Funktionalitäten der Plattform. Dann ging sie detailliert auf die Funktionen und Inhalte der GND-Dokumentation ein. Besonders relevant ist in diesem Zusammenhang, dass der bereits erprobte offene Redaktionsprozess für den Standard RDA DACH künftig auch Diskussionen zu den Regeln in der GND-Dokumentation ermöglicht. Damit können community-spezifische Bedarfe durch Anwendergruppen und solche allgemeiner Natur adressiert und transparent umgesetzt werden. Die gesamte text- und abbildungsreiche Präsentation ist nebenstehend nachzulesen.

Zum Lesen bitte auf die Abbildung klicken.

Die Folien von Andrea Hemmer (DNB) als PDF.

Feedback gewünscht

Zentrales Element des Workshops war selbstverständlich das eigenständige Testen der Dokumentation durch die Teilnehmenden selbst. Aufgeteilt in kleine Gruppen versuchten sie die nebenstehenden Aufgaben zu lösen. Ausgangspunkt war der Bedarf, einen regelkonformen GND-Datensatz zur Nadia Boulanger anzulegen.

Alle Teilnehmenden lösten die Aufgabe ohne Probleme. Der GND-Datensatz zu “Boulanger, Nadia” sollten mit dem Entitätencode piz, dem Ländercode XA-FXFR, den Lebensdaten * 16. September 1887 † 22. Oktober 1979 korrekt verknüpft werden, außerdem wären die Angaben zum Geburts-, Sterbe- und Wirkungsort als weitere Individualisierungsmerkmale, hier jeweils “Paris”, ebenso wie die Angabe ihres Berufes “Komponistin” ergänzt durch die Bezeichnung der Relationierung zu dem bereits vorhandenen GND Datensatz ihrer Schwester Lilli möglich. Die Leser*innen mögen selbst die Aufgabe in der GND-Dokumentation nachvollziehen, vielleicht zunächst ohne den in der obigen Lösung angegebenen Links zu folgen.

Natürlich fällt es jemandem, der nur sehr selten einen GND-Datensatz anlegen möchte, schwerer, sich in der Dokumentation zurecht zu finden als jemandem, zu dessen täglichen Aufgaben die GND-Arbeit gehört. Die Dokumentation bietet keine Eingabemaske für Entitätstypen, sondern bildet nur die Regeln zu deren Erfassung ab. Im Einzelfall kann eine detaillierte Schreibanweisung beim Anlegen von Datensätzen helfen. Neben kleineren Hinweisen zur Verbesserung der Verständlichkeit, wie der Erläuterung des Bibliotheksterms “Sucheinstieg”, lobten die Teilnehmenden die gute Verständlichkeit der Texte, die Erläuterungen mit Beispielen und das Farbkonzept zur leichteren Orientierung. Der für das zweite Quartal 2026 geplante dritte Feedbackworkshop wird sich dann den bis dahin hoffentlich vorliegenden Trainingsmaterialien zur GND-Doku widmen. Wir werden Sie informieren.

Bis dahin testen Sie gern selbst die GND-Dokumentation und lassen Sie uns Ihren persönlichen Kommentar zukommen. Auf jeder Seite der STA-Dokumentationsplattform finden Sie unten in der Menüleiste ein kleines Sprechblasen-Symbol; dies öffnet eine E-Mail an die Arbeitsstelle für Standardisierung mit dem entsprechenden Weblink in der Betreff-Zeile. Schreiben Sie uns, wenn Sie einen Tippfehler, einen Textfehler, eine Anmerkung oder ein Lob hinterlassen möchten. Wir freuen uns.

Zum Lesen bitte auf die Abbildung klicken.

Screenshot der Aufgaben im Feedbackworkshop zur GND-Dokumentation

Dokumentation des vierten projektübergreifenden Agenturentreffens am 30.9. 2025 an der Deutschen Nationalbibliothek in Frankfurt am Main

Ein Online-Workshop der IG Archiv zur Erörterung des Bedarfs an Lernangeboten zur Arbeit mit der Gemeinsamen Normdatei (GND)

Die Dokumentation

Rund 80 Teilnehmende folgten der Einladung der Interessengruppe Archiv im Netzwerk der GND sich mit dem Thema “Wie lernt man Normdaten nutzen und schaffen?” aktiv auseinanderzusetzen. Der Workshop war öffentlich und fand am 19. September 2025 online statt. Die Teilnehmenden kamen aus allen Archivsparten und mit ganz unterschiedlichen Vorkenntnissen zum Thema Normdaten allgemein und der GND im Archiv im Besonderen. Den unterschiedlichen Voraussetzungen der Teilnehmenden wurde die Veranstaltung gerecht, indem sie einerseits bestehende, zum Teil einführende Handreichungen speziell für Archivmitarbeitende vorstellte, die die IG Archiv jüngst veröffentlicht hat:

Einsatz von GND-Normdaten im Archiv : archivische Relevanzkriterien | Die GND im Archiv : Handreichung zur Nutzung von Normdaten | Tipps & Tricks für die erfolgreiche Nutzung von Tools zum Einsatz der GND im Archiv |

| Version 1.1 (August 2025) | ||

Dazu auch der Vortrag von Dr. Stephanie Marra, Universitätsarchiv Dortmund Zum Lesen klicken | Dazu auch der Vortrag von Dr. Johannes Haslauer, Staatsarchiv Bamberg Zum Lesen klicken |

Zum anderen bot der Vortrag von Barbara Fischer (DNB) zum derzeitigen Angebot von Informations- und Lehrmaterialien zur Nutzung und Mitarbeit in der GND einen Einstieg in die Diskussion zu den spezifischen Bedarfen der Community.

Zum Lesen klicken

Letztlich zeigte die Diskussion, dass nach wie vor viele der bestehenden Angebote und Materialien noch nicht hinreichend bekannt sind. Dem will die IG Archiv künftig durch verstärkte Vermittlungsarbeit Rechnung tragen. Aufgeworfene Fragen und Bedarfe betrafen im Weiteren das Angebot an unterstützenden GND-Agenturen in der jeweiligen Region bzw. Archivsparte, die verbesserte Verankerung des Themas Normdaten zur Referenzierung transinstitutioneller Bestände in der Aus- und Fortbildung von Archivar*innen sowie schließlich die Anleitung zur integrierten Nutzung von Normdaten in unterschiedlichen Archiv-Informationssystemen. Thematisiert wurde ebenfalls die Methode der Vermittlung: Kurse mit Interaktionsmöglichkeiten für Lernende erscheinen vielfach attraktiver als Lernangebote zum Selbststudium. Insbesondere dem Thema “GND-Agentur”, Aufgaben und Einrichtung, wurde viel Bedeutung zugesprochen. Darauf soll eine künftige Veranstaltung der IG Archiv näher eingehen.

Veranstaltungshinweise zum Thema Schulung und Normdaten

Ergänzend und erweiternd noch die gesammelten Hinweise der Teilnehmenden zu passenden Veranstaltungen oder Material und eine Sammlung von weiterführenden Links, die im Chat oder auf den Folien Erwähnung fanden:

- BSZ Schulungen: https://wiki.bsz-bw.de/spaces/SWB/pages/3444994/Schulungen für (bibliothekarische) Verbundteilnehmer hier u.a. RDA- und GND-Schulungen, verschiedene Termine pro Jahr

- Archivämter der Landschaftsverbände in Nordrhein-Westfalen:

- LWL-Archivamt Münster: GND wird integriert behandelt in Fortbildungsseminaren z.B. zur Fotoarchivierung (https://www.lwl-archivamt.de/de/aus-und-fortbildung-fachtagung/fortbildungsseminare/fortbildungsseminare/);

- LVR-Archivamt Pulheim: GND war auch Thema der diesjährigen "Summer Lectures" (siehe Vortrag von Dr. Andreas Marquet, Archiv der sozialen Bewegung der FES: https://afz.lvr.de/de/presse/meldung/meldung_37376.html); ggf. GND thematisiert im Hackathon des LVR-AA zur Sichtbarkeit von ARchivdaten im Archivportal NRW (https://ems.lvr.de/microsite/index.cfm?l=35E27F3C259023AEC3189AF5460F6671&sp_id=1)

- SODa = Datenkompetenzzentrum für Universitätssammlungen (hauptsächlich, aber nicht nur!) bietet Veranstaltungen rund ums Forschungsdatenmanagement sowie OpenRefine-Sprechstunden an: https://sammlungen.io/events bzw. generell zu SODa (Intention, Projekte, Publikationen etc.): https://sammlungen.io/

- Die Vortragsreihe „From Books to Bytes“ stellt regelmäßig aktuelle Themen und relevante Anwendungsfelder vor (alle Vortragsaufzeichnungen auf Youtube vorhanden)

- AS Marburg: in einem mehrtägigen Fortbildungsseminar von Herrn Björn Steffenhagen M.A. (Wiss. Archivar am LA Sachsen-Anhalt) wird die GND-Verwendung im Archiv mit hematisiert, "Semantische Technologien und der Einsatz von Normdaten in der archivischen Erschließung", Link findet auch 2026 wieder statt

- Das Schulungsangebot zum GND Webformular der GND Agentur Leo BW regional Weitere Infos & Anmeldung unter link

Nützliche Links aus dem Chat und von den Folien:

- Einführungsvortrag zur GND in den Archiven: “Einfach normiert für Archive”, 2024, von Barbara Fischer (DNB) https://zenodo.org/records/11086254

- E-Learnings zur GND Nutzung und Anwendung https://gnd.network/Webs/gnd/DE/UeberGND/Infothek/E-Learning/eLearning.html

- Die benutzerfreundliche Recherche von GND IDs unterstützt der GND explorer https://explore.gnd.network/

- Zum öffentlichen Bereich der IG Archiv im STA Community Netzwerk https://wiki.dnb.de/display/STAC/IG+Archiv

- Alle bisher erschienenen Papiere der IG Archiv finden sich hier: https://wiki.dnb.de/display/STAC/IG+Archiv+%7C+Dokumente

- Was sind Normdaten? Ein Video von NFDI4Culture https://av.tib.eu/media/60986

- Die Dokumentation der Regeln zur Erstellung von GND Datensätzen https://sta.dnb.de/doc/GND

- Abgleich 'unsauberer' Ortsnamen mit der GND in OpenRefine: https://histocat.uni-trier.de/#/document/43

Die im Standardisierungsausschuss organisierten Einrichtungen sowie die regionalen und nationalen Bibliotheksverbünde im deutschsprachigen Raum mit ihren weit über 1000 Mitgliedern empfehlen, Normdaten in Kultur und Forschung für das Daten- und Qualitätsmanagement als notwendige Daueraufgaben entsprechend zu behandeln und auszubauen.

Im Rahmen des DFG-geförderte Projekt PID Network Deutschland werden von den Betreibern ausgewählter PID-Systemen Statements formuliert, in denen sie sich zu den Punkten Status Quo, Serviceangebote und Empfehlungen für die zukünftige Nutzung ihres PID-Systems Leitlinien äußern. Diese Statements fließen in eine umfassende nationale PID-Roadmap ein. Die Roadmap wird sich zum einen direkt an Kulturgut bewahrenden Einrichtungen und Forschungsinstitutionen richten und zum anderen an Fördermittelgeber der öffentlichen Hand. Als erste veröffentlicht die Deutsche Nationalbibliothek als Trägerin der Gemeinsamen Normdatei ihr Statement zur GND. Die GND ist die größte Normdatensammlung für Kultur- und Forschungsdaten im deutschsprachigen Raum. Die Metadaten zu Objekten in Wissenschaft und Kultur werden mit der Verwendung von GND-Normdaten mit ihren persistenten Identifikatoren (GND-IDs) sichtbarer und können in internationale Infrastrukturen eingebunden werden. Die GND-IDs fördern die umfassende Vernetzung von Kulturerbe und Wissenschaft. Das Statement findet die volle Unterstützung sowohl der GND-Kooperative selbst als auch des Standardisierungsausschusses als höchstes Steuerungsgremium der GND-Kooperative.

Die Empfehlung in Gänze im nebenstehenden PDF zum Download und zur Weiterverwendung.

eine Leseempfehlung

zum Thema diskriminierende Begriffe in der Gemeinsamen Normdatei

In die Diskussion um den Umgang mit diskriminierenden Begriffen in der GND ist Bewegung gekommen. Guido Bee hielt hierzu einen Vortrag auf dem Österreichischen Bibliothekskongress im Wien, der jetzt im DNB-Blog unter dem Titel „Wörter und ihr Gefahrenpotenzial“ veröffentlicht wurde. Der Beitrag ist auch deshalb von Interesse, weil er die kooperative Arbeit der GND-Verbundpartner mit einem Fachinformationsdienst, hier dem FID Sozial- und Kulturanthropologie, näher vor Augen führt. Der Text weist einige Berührungspunkte mit einem Vortrag von Martin Völkl zum Umgang mit kolonialen Kontexten in der GND auf, den dieser am 6. Mai bei einer Sitzung des GND-Ausschusses präsentierte. Beide Beiträge lassen die Komplexität der Thematik erkennen, zeigen aber auch Möglichkeiten auf, in schwierigen Fällen zu praktikablen Lösungen zu gelangen.

Die Visualisierung des Schlagwortes Diskriminierung im GND-Explorer

Der vollständige Text von Guido Bee ist hier zu finden https://blog.dnb.de/woerter-und-ihr-gefahrenpotenzial/

Die Folien von Martin Völkl sind hier verlinkt.Eine Dokumentation verfertigt von Renz, Johannes

Veranstaltungsankündigung:

PIDs für wissenschaftliche Veranstaltungen: Mehr Sichtbarkeit & Nachhaltigkeit

Dieser Workshop beleuchtet den Einsatz von Persistente Identifikatoren (PIDs) für akademische Veranstaltungen wie Konferenzen und Workshops.

Neben der GND gibt es noch eine Vielzahl anderer Persistent Identifier Systeme (PID), die zum Teil auch Normdaten sind. In diesem Workshop geht es um die dauerhafte Kennung wissenschaftlicher Veranstaltungen. Wer braucht solche Daten? Wer bietet solche Daten an und wie unterscheiden sich die Systeme. Darauf versuchen die Vortragenden und Teilnehmenden Antworten zu finden. Das nebenstehende Programm liefert die Details zu den Perspektiven.

Die Teilnahme ist vor Ort in Hannover aber auch online möglich. Voraussetzung ist jedoch die Anmeldung über diesen Link: https://events.hifis.net/event/2232/registrations/

Im Workshop:

- Diskutieren wir die Vorteile von PIDs für verschiedene Stakeholder (Forschende, Veranstalter, Verlage etc.)

- Präsentieren Tools & Plattformen, die PIDs nutzen

- Erkunden den Lebenszyklus wissenschaftlicher Veranstaltungen und wie Metadaten ihn effektiv beschreiben können

Der Workshop zu PIDs für wissenschaftliche Veranstaltungen findet im Rahmen der Veranstaltungsreihe des DFG-geförderten Projekts PID Network Deutschland statt. Ziel des Workshops ist es, die Rolle von PIDs bei der Optimierung von Organisation, Sichtbarkeit, Integration und Qualitätskontrolle akademischer Veranstaltungen in akademische Informationsinfrastruktursysteme näher zu beleuchten.

Die Vorträge finden in deutscher und englischer Sprache statt (Details siehe Tagesordnung). Alle Folien werden in englischer Sprache sein.

Termin: 07. Mai 2025 von 09:00 bis 16:00 Uhr

Ort: Hannover oder online

Anmeldung: https://events.hifis.net/event/2232/registrations/

Zielgruppe: Forschende, Verlage, Institutionen als Veranstalter wissenschaftlicher Veranstaltungen wie Konferenzen, Tagungen, Workshops ...

Tagesordnung (online und vor Ort)

Sprecher: Christian Hauschke (TIB)